Abstracts

Résumé

En Suisse, en formation professionnelle initiale dans la branche du commerce de détail, la diplomation passe par l’examen pratique dans l’entreprise formatrice de l’apprenti. Cet examen, certificatif et éliminatoire, dure entre une heure et une heure et demie, selon le type de formation. Il est conduit par deux professionnels du domaine nommés experts. Les buts de cette étude sont, d’une part, de comprendre la validité attribuée par les experts à l’examen pratique et, d’autre part, de définir les raisons de cette évaluation. Pour y parvenir, un échantillon de 189 experts a répondu à un questionnaire sur la validité de cet examen. Les données ont été traitées par des analyses factorielles exploratoires. Nous avons ensuite extrait trois profils d’experts par classes latentes. Les résultats de cette étude ont permis de mettre en évidence, parmi les experts, une hétérogénéité de profils. Ils se différencient selon leur expérience en tant qu’expert et selon leur langue.

Mots-clés :

- classes latentes,

- évaluateur,

- évaluation,

- examen certificatif,

- formation professionnelle initiale

Abstract

In Switzerland, at the end of their initial vocational education, retail apprentices take a practical examination at the company where they are being trained. This examination, which is both certifying and eliminating, lasts between one and one and a half hours, depending on the type of training. It is conducted by two professionals in the field known as examiners. The objectives of this study are, firstly, to understand the validity attributed to the practical examination by the examiners and, secondly, to define the reasons for this assessment. To achieve this, a sample of 189 examiners answered a questionnaire on the validity of this examination. The data were processed by exploratory factor analysis, and three expert profiles were extracted by latent classes. The results of this study highlighted the heterogeneity of the examiners profiles. They differ according to their experience as examiners and their language.

Keywords:

- assessment,

- certificate examinations,

- examiner,

- latent classes,

- vocational education

Resumo

Na Suíça, na formação profissional inicial no setor do comércio a retalho, a atribuição de diplomas é feita através de um exame prático realizado na empresa formadora do aprendiz. Este exame, de caráter certificativo e eliminatório, tem uma duração de uma hora a uma hora e meia, dependendo do tipo de formação. É conduzido por dois profissionais da área, designados como peritos. Os objetivos deste estudo são, por um lado, compreender a validade atribuída pelos peritos ao exame prático e, por outro, identificar as razões dessa avaliação. Para tal, foi utilizado um questionário sobre a validade do exame, respondido por uma amostra de 189 peritos. Os dados foram analisados por meio de análises fatoriais exploratórias, a partir das quais foram extraídos três perfis de peritos através de classes latentes. Os resultados deste estudo evidenciaram uma heterogeneidade de perfis entre os peritos, diferenciando-se pela sua experiência enquanto peritos e pela sua língua.

Palavras chaves:

- avaliação,

- avaliador,

- classes latentes,

- exame certificativo,

- formação profissional inicial

Article body

Introduction[1]

En Suisse, la formation professionnelle initiale (FPI) en alternance (duale) est bien implantée. Les apprentis signent un contrat avec une entreprise formatrice (entreprise) qui va les former et les employer deux à trois jours par semaine. Une autre partie de leur temps est consacrée à la formation en école professionnelle, une troisième aux cours interentreprises conformément aux directives du secrétariat d’État à la formation, à la recherche et à l’innovation (SEFRI) (2022). Ainsi, les apprentis sont formés selon une orientation vers le marché du travail leur permettant d’exercer leur profession de manière autonome (SEFRI, 2022). Les compétences sont évaluées en continu et en fin de formation ; les jeunes subiront donc différentes évaluations. L’une d’elles, intitulée examen pratique, est singulière à plusieurs égards. L’examen est sommatif et l’apprenti doit obtenir une note suffisante pour obtenir son diplôme. L’examen pratique, qui se déroule dans l’entreprise de formation de l’apprenti, dure 60 ou 90 minutes, selon le type de formation, suivi d’une correction de 30 minutes. Deux évaluateurs, qui sont des professionnels actifs du métier, conduisent l’examen. Ils doivent venir d’une autre entreprise que celle de l’apprenti. Ils sont nommés « experts en entreprise » mais dans le langage courant, seul le terme « expert » est utilisé.

Cette importante voie de formation est abondamment documentée par la recherche scientifique. Les travaux portent sur le bon déroulement de la formation et s’interrogent sur les raisons qui expliquent les 20 à 25 % de résiliations prématurées des contrats d’apprentissage (Kriesi et al., 2016 ; Réjane, 2023 ; Schmid & Stalder, 2008), la coordination entre les divers lieux de formation (Berger et al., 2021, 2023 ; Frey, 2010) ou l’avenir professionnel des diplômés (Gomensoro et al., 2017 ; Stern et al., 2010). Les informations disponibles sur les examens pratiques ne sont pas des recherches mais des opinions. Celles-ci portent sur la pertinence et sur la justice, selon des facteurs liés à l’encadrement des apprentis et la qualité fluctuante de la formation (Kuster, 2011) ou le moment de passation des examens (Tellenbach, 2022). Ces travaux portent sur le déroulement de la FPI selon les interactions entre entreprises, écoles ou débouchés professionnels. Notre recherche propose de combler ce vide en questionnant, par une méthode scientifique, les experts sur la validité accordée aux examens pratiques.

Nous pensons que l’examen pratique est un moment complexe et intéressant de questionnement de l’expert sur son identité professionnelle. En effet, en période d’examen pratique, l’expert applique la référentialisation, au sens de Figari (1994), en comparant l’écart entre ce qu’il observe et ce qu’il aimerait observer chez l’apprenti. Cette référentialisation atteint un niveau de complexité supérieur, d’une part, par la présence d’un deuxième expert avec qui il faut négocier les résultats et, d’autre part, par un protocole d’examen qui représente le référent officiel et qui peut différer du référent de l’expert. Ces tensions seront analysées grâce au modèle des transactions identitaires (Perez-Roux, 2016) et à plusieurs types de perception de la validité (Penta et al., 2005).

Problématique et objectifs

Une évaluation de Kägi (2010), conduite par la Confédération suisse, a été réalisée auprès des associations faîtières formatrices, des entreprises, des écoles et des personnes en formation. Il en ressort que l’évaluation de la formation des experts aux examens est estimée suffisante à 25 % et insuffisante à 18 %. Les remarques principales issues de ce rapport sont qu’il y a trop peu de cours de formation continue pour les experts et que les intervalles entre ces cours sont trop longs. Les formations sont associées aux réformes des lois ou des procédures d’examen, qui sont habituellement réalisées chaque cinq ou dix ans. De plus, le fait que certains professionnels exercent sans la formation adéquate ou que le manque de professionnels permette à des personnes non formées d›exercer cette fonction a aussi été mentionné comme sujet à caution. Une autre problématique ressort dans une étude sur le degré d’accord entre les experts (Jan, 2023) réalisée selon la méthode Angoff (Angoff, 1984 ; Bain, 2017). Cette méthode demande aux experts d’imaginer un panel de 100 apprentis minimalement compétents, c’est-à-dire aptes à résoudre les questions, mais toujours avec la note la plus basse pour que l’examen pratique soit considéré comme suffisant. Les experts ont pris, une à une, chaque question de l’examen pratique et estiment combien de ces 100 participants minimalement compétents répondraient correctement à chacune des questions. Pour cette étude, six experts expérimentés ont dû évaluer chaque question de l’examen pratique selon cette méthode. Ces experts comptent plus de 10 ans d’expérience, ont expertisé plus de 100 apprentis et préparent chaque année des apprentis pour les examens pratiques. Le protocole d’examen utilisé est la version libre d’accès permettant, tant aux apprentis qu’aux formateurs, de préparer l’examen pratique. Les résultats ont montré de fortes divergences entre les experts. Par exemple, selon l’un des plus grands écarts, un expert a estimé que 30 apprentis minimalement compétents répondraient correctement à la question, tandis qu’un autre a évalué qu’ils seraient 95 à répondre correctement à la même question. Ainsi, la divergence entre ces deux experts est de 65 points. La divergence moyenne dans chacune des questions a été de 45 points (Jan, 2023) pour un accord inter experts de 0,39 selon le test α de Krippendorff (Hayes & Krippendorff, 2007).

Nous voyons, au travers de ces deux exemples, que l’évaluation de cet examen pratique par les experts est, d’une part, vue comme aléatoire (Kägi, 2010) et que, d’autre part, des experts, même très expérimentés, peuvent donner des évaluations très différentes malgré un protocole d’examen identique (Jan, 2023).

La fonction d’expert

Les experts sont des professionnels actifs dans le domaine alimentaire du commerce de détail. La majorité fonctionne en tant que directeur d’un supermarché. Ils sont tenus d’avoir un minimum de trois ans de pratique et de détenir un diplôme identique ou supérieur à celui qu’ils vont expertiser. Ces professionnels peuvent obtenir le titre d’expert aux examens pratiques à la suite d’une participation à une formation de deux jours selon l’Ordonnance sur la formation professionnelle du SEFRI (2004). La première journée, intitulée cours de base, est commune à toutes les branches de la professionnelle initiale. Durant celle-ci sont abordés les rôles et les tâches des experts conformément aux dispositions légales. La deuxième journée, intitulée cours spécifique, regroupe les experts selon leurs branches de fonctionnement. Lors de cette journée, des informations pratiques liées à l’examen pratique sont présentées : l’utilisation des protocoles d’examen, la gestion du temps et les bonnes pratiques à appliquer lors de situations particulières avec un apprenti.

Les experts sont choisis pour leur posture évaluative, mais également pour leur sagesse pratique (Delahais et al., 2021) du métier. Ceci implique que leurs pairs les considèrent comme des professionnels compétents ayant une attitude valorisante à l’égard de la profession, de la procédure de qualification et de l’apprenti.

Le déroulement de l’examen pratique

Les examens pratiques se déroulent chaque année durant le mois de mai, le mois de juin étant consacré aux examens en école professionnelle.

Il s’agit d’une évaluation pratique située (Brown et al., 1989 ; Mottier Lopez et Allal, 2008) qui se déroule dans l’entreprise où l’apprenti fait sa formation.

Il existe deux diplômes : assistant et gestionnaire du commerce de détail. La formation de gestionnaire prend trois ans et l’examen pratique dure 90 minutes, tandis que la formation d’assistant prend deux ans et l’examen pratique dure 60 minutes. La formation d’assistant s’adresse aux personnes rencontrant des difficultés scolaires et le temps consacré à l’école est moindre que pour la formation de gestionnaire. Durant l’examen pratique des assistants, le niveau de complexité des questions, selon la taxonomie de Bloom (1969), est plus bas et la durée de l’examen est raccourcie de 30 minutes. Hormis ces deux différences, les experts évaluent les deux formations de la même manière et selon des protocoles similaires.

Directement après l’examen, pendant quelque 30 minutes, les experts négocient et attribuent les points par concertation (Reuter et al., 2013) à chaque question. Le total final permet de calculer la note d’examen pratique qui est ensuite transmise au coordinateur. L’apprenti n’est pas présent durant la correction.

La pratique d’évaluation n’est pas celle d’un professeur qui évalue son élève après l’avoir accompagné et formé durant plusieurs années. Nous sommes plus proches d’une évaluation de type externe (Merle, 2018) ou institutionnelle (Perrenoud, 2010). C’est la rencontre entre des professionnels qui connaissent le domaine et viennent pour réaliser leur fonction évaluatrice. Cependant, les experts ne connaissent spécifiquement ni l’apprenti ni l’entreprise visitée. Des situations inédites et déstabilisantes pour l’apprenti peuvent en découler. Par exemple, les experts peuvent demander de quelle manière sont choisis les emplacements des zones promotionnelles du magasin alors que cette entreprise ne laisse pas aux employés la possibilité de les choisir.

Les experts évaluent si les compétences opérationnelles (Seufert, 2018) fixées par le plan de formation sont atteintes (Formation du Commerce de Détail Suisse, 2021a, 2021b). Les compétences opérationnelles, dont la définition originale en allemand Handlungskompetenz décrit mieux le concept, sont les compétences à réaliser des actions. Ainsi, les apprentis ne doivent pas décrire qu’ils savent faire une tâche, mais le démontrer par une action en situation permettant une évaluation située (Vial, 2012). Ces compétences sont le résultat d’une pratique régulière en entreprise ainsi que d’un aller-retour entre la théorie et la pratique (Perrenoud, 2000). Concrètement, par l’examen pratique, l’apprenti est mis en action dans des situations proches de son travail quotidien. Par exemple, les experts passent en caisse avec une série de produits et évaluent la manipulation de la marchandise, le respect des consignes légales et de sécurité, mais également les compétences sociales dans la manière de dialoguer tout en travaillant. Le niveau de complexité de chaque question est défini selon la taxonomie originelle de Bloom (1969).

Bien que l’examen pratique soit axé sur des compétences opérationnelles, issues des pratiques professionnelles (Le Boterf, 2010), l’évaluation n’est pas formative et ne sera pas une base permettant à l’apprenti de s’améliorer (Scriven, 1996). En fin d’examen pratique, l’apprenti ne recevra aucun commentaire sur sa prestation. C’est une évaluation à fonction certificative qui doit permettre de certifier que l’apprenti peut être considéré comme un employé qualifié.

Le protocole de l’examen pratique

La structure de base du protocole de l’examen pratique définit le nombre de questions par domaine, le niveau taxonomique et le temps de chaque question. Elle est réalisée par Formation du Commerce de Détail Suisse. Les questions de l’examen pratique sont générées automatiquement selon un échantillonnage de questions stratifiées (Laveault & Grégoire, 2014) depuis une plateforme informatique permettant une adaptation selon les différents types d’entreprises. Cette construction automatisée et structurée des examens pratiques fait que : a) les experts ont un protocole différent d’un apprenti à l’autre ; b) le protocole est adaptable au type d’entreprise visitée (petit magasin de village, grand magasin ou magasin spécialisé) ; c) l’examen porte sur l’ensemble des compétences du métier et ne se focalise pas sur un domaine en particulier.

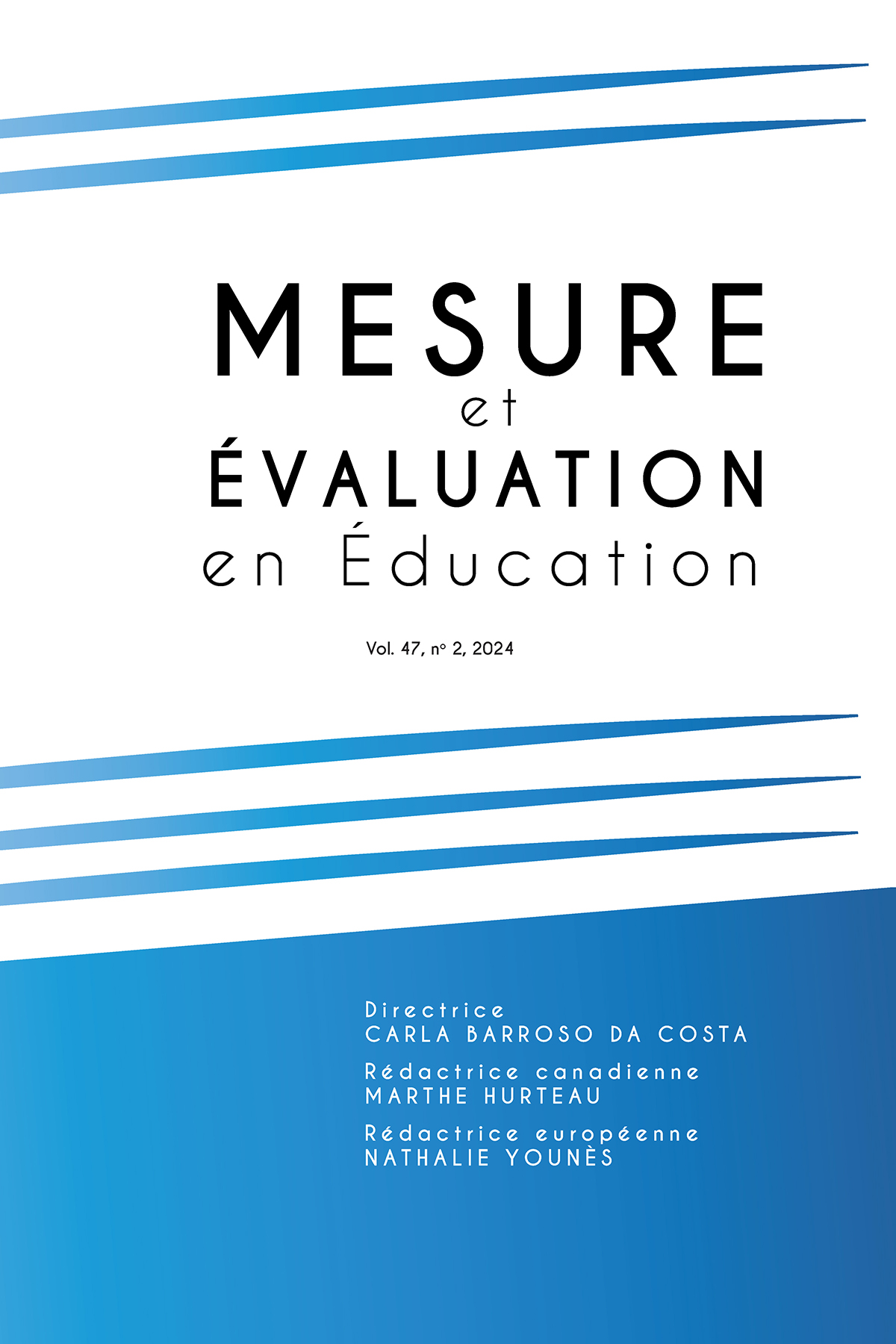

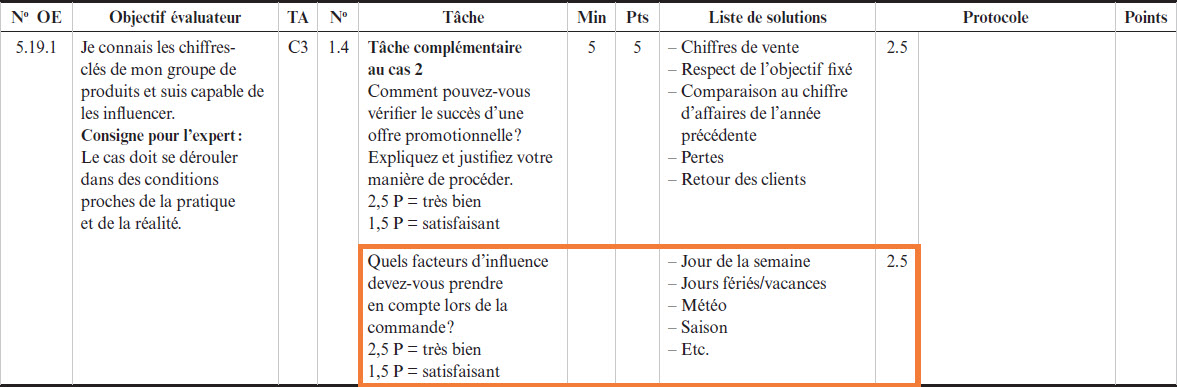

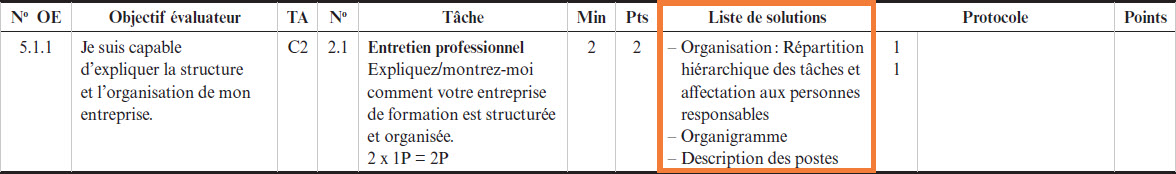

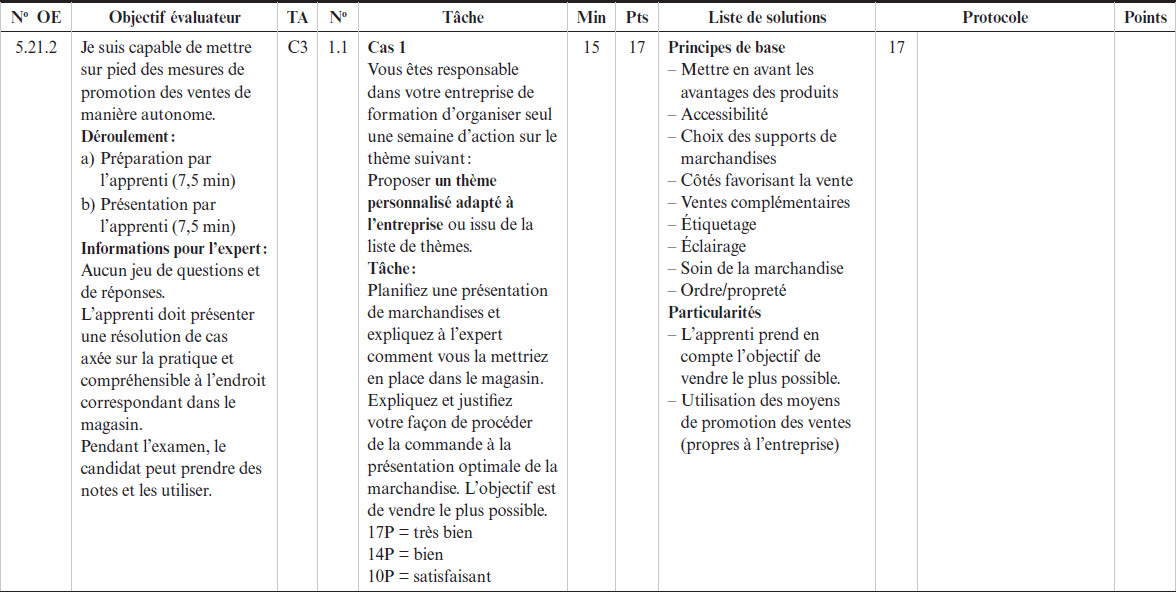

Chaque question (voir exemple en figure 1) propose une série de solutions probables dans la colonne intitulée Liste de solutions ainsi qu’une zone libre intitulée Protocole qui permet de noter la réponse de l’apprenti. Les experts sont libres d’utiliser une zone ou l’autre, voire les deux, le plus important étant de noter les informations nécessaires pour retracer le déroulement de l’examen pratique lors de la l’évaluation par les deux experts.

Figure 1

Question issue d’un protocole de l’examen pratique

Les autres zones de la figure 1 décrivent des informations administratives telles que la source ayant servi à la construction de la question, le temps ainsi que le nombre de points attribués à la question.

Cadre théorique

Comme le montre le protocole de l’examen pratique, les experts sont très encadrés dans la réalisation de leur fonction d’évaluateur et les questions à poser leur sont fournies. Mais, en même temps, le processus de l’examen pratique fait que les experts vont évaluer des apprentis et des entreprises qu’ils ne connaissent presque pas. Pour mieux saisir ce dilemme, nous testerons la perception qu’ont les experts de la validité de l’examen (Penta et al., 2005). Ces types de validité seront intégrés dans le modèle de transactions identitaires (Perez-Roux, 2016) démontrant comment la référentialisation (Figari, 1994) faite par les experts pour réaliser leur évaluation dans un contexte simultanément cadré est une source d’instabilité qui peut être reliée à leur identité professionnelle.

La validité de l’examen

Dans une première phase, nous testons la validité (Anastasi & Urbina, 1996 ; Laveault & Grégoire, 2014 ; Nevo, 1985 ; Penta et al., 2005) que les experts accordent à l’examen. Lors de la deuxième phase, les facteurs de validité construits servent à réaliser des profils d’experts par le recours à une analyse en classes latentes. Ces profils serviront dans la troisième phase afin de mieux comprendre la référentialisation (Figari, 1994) faite par les experts.

Parmi les six types de validité (Penta et al., 2005), nous en utilisons trois :

-

La validité de contenu interroge les experts sur l’examen pratique en tant qu’outil de qualité pour évaluer le professionnalisme des apprentis. Par exemple, est-ce que les questions reflètent effectivement le travail quotidien des apprentis (Laveault & Grégoire, 2014 ; Penta et al., 2005)?

-

La validité apparente interroge la qualité apparente de l’examen. Les experts sont des professionnels du commerce de détail, mais pas de la pédagogie ou du plan de formation dont sont issues les questions des examens pratiques. Cette validité porte ainsi sur la valeur apparente et non réelle de l’examen pratique (Penta et al., 2005). Cette mesure est importante, car elle indique la légitimité et le crédit que les experts accordent au protocole d’examen pratique (Anastasi & Urbina, 1996). Par exemple, est-ce que les tournures de phases limitent la compréhension des questions?

-

La validité de conséquence représente la perception de l’adéquation entre les questions de l’examen pratique et le magasin où se déroule l’expertise. (Laveault & Grégoire, 2014 ; Nevo, 1985 ; Penta et al., 2005). Cette validité permet de prendre en compte les conséquences de l’utilisation du protocole d’examen pratique sur l’évaluation de l’examen pratique lui-même (Messick, 1988). Par exemple, est-ce que les réponses des apprentis correspondent à la liste des solutions?

Précisons que ces trois validités sont questionnées selon les perceptions qu’ont les experts de la validité de l’examen pratique. Ce n’est pas l’examen pratique qui est testé, mais la démarche de mesure (Loye, 2019) avec l’examen pratique pour s’acquitter correctement la fonction d’expert.

Les trois autres types de validité (Penta et al., 2005), en référence à un critère concomitant, prédictif ainsi que conceptuel ne questionnent pas les experts sur l’examen. Ces critères questionnent la validité de l’examen pratique par rapport à d’autres examens et, pour cette raison, ils ne sont pas pertinents pour cette étude.

Les profils des experts

La procédure de construction des profils par l’analyse en classes latentes est présentée dans les résultats. Ainsi, nous passons à la référentialisation (Figari, 1994) selon ces différents profils.

Lors de l’évaluation, l’expert se base sur un référentiel (Figari, 1994, 2006) qui n’est pas un objet de référence préexistant, mais une construction éphémère et personnelle cognitivement mobilisée durant l’examen. Ce référentiel est conçu comme l’outil étalon servant à évaluer l’écart qui existe entre le référent, désignant ce que l’on souhaiterait observer ou constater, et le référé, correspondant à la réalité que l’on observe lors de l’examen pratique en contexte réel. Le référent est multidimensionnel : il entremêle les attentes de l’expert selon ses propres critères de qualité, les besoins du marché, le type d’entreprise visité et son état d’esprit du moment, ainsi la conception même de la fonction d’expert (Issaieva & Crahay, 2010) qui est propre à chacun. Les experts évaluent les apprentis selon ce qu’ils vont montrer et démontrer durant l’examen pratique, défini par Hadji comme les signes parlants (2012). Ces signes parlants, ou indices, sont issus des pratiques professionnelles (Le Boterf, 2010) que les experts veulent constater dans la prestation de l’apprenti.

L’examen pratique a une fonction certificative, mais la démarche de cette évaluation peut être sommative ou herméneutique (De Ketele, 2010) : sommative, car l’obtention d’une note suffisante est obligatoire pour prétendre à la diplomation, mais également herméneutique, car l’examen pratique avait du sens selon les pratiques professionnelles afin de garantir les acquis d’un futur employé qualifié (Mottier Lopez, 2015). Des biais entrent également en action par la méconnaissance de l’entreprise expertisée puisque l’expert n’est jamais expert dans sa propre entreprise. Ainsi, un effet-entreprise, par analogie à l’effet-école (Grisay, 2006), peut apparaitre ; les experts peuvent être influencés par la réputation des entreprises. Le jugement des experts (Bressoux, 2018) peut, en partie, se construire selon les préjugés sur les entreprises qui deviennent la réputation de l’apprenti expertisé.

Ainsi, la référentialisation (Figari, 1994) est la phase centrale de l’action d’évaluation, car on justifie le résultat, non de manière absolue, mais de manière relative au cadre d’un examen pratique spécifique selon l’écart mesuré entre référent et référé.

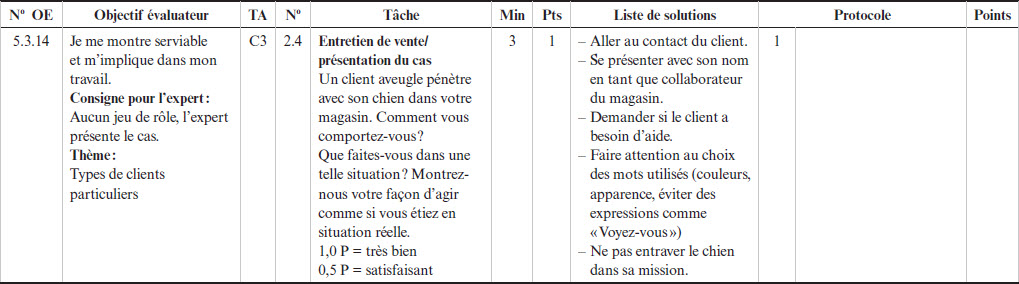

L’identité professionnelle

Le référé (Figari, 1994) peut être double : d’une part, il y a celui de l’expert que l’on vient de présenter mais, d’une autre part, il y a le référé officiel, soit l’examen pratique. Afin d’expliquer de quelle manière le référent, le référé de l’expert et le référé officiel coexistent, nous utiliserons une version adaptée du modèle des transactions identitaires de Perez-Roux (2016), illustré en figure 2, pour présenter le processus complexe et dynamique de l’accompagnement en formation.

L’identité professionnelle de l’expert, durant ses expertises, est tiraillée entre plusieurs dimensions. La précision « durant ses expertises » est importante, car l’expert quitte son contexte habituel pour aborder une entreprise peu connue, afin d’évaluer un apprenti inconnu avec un deuxième expert souvent côtoyé uniquement dans le cadre de cette fonction. Ainsi, l’identité professionnelle de l’expert n’est pas figée durant les expertises. La référentialisation (Figari, 1994) de l’expert fluctue selon les dimensions et le(s) contexte(s) de la transaction identitaire (Perez-Roux, 2016). Selon l’axe horizontal, afin de garantir la conformité de l’évaluation officielle, les experts doivent se référer à la structure figée de l’examen pratique mais doivent également évaluer si les compétences de l’apprenti correspondent aux critères actuels du métier. L’axe vertical demande des ajustements entre la propre représentation de l’expert du métier, ses critères quant au travail bien fait et ce qui est demandé par l’examen, mais également des attentes quant aux compétences du métier, telles que définies par le deuxième expert. La référentialisation (Figari, 1994) est l’association que l’expert fait entre ses diverses transactions identitaires, son collègue expert, le protocole d’examen et l’apprenti expertisé.

Figure 2

Transactions identitaires (Adapté de Perez-Roux, 2016, p. 4)

Dans le modèle présenté en figure 2, l’examen pratique est un objet invariable qui se positionne dans la continuité. Nous positionnons également les trois types de validité retenues. D’abord, la validité apparente, qui évalue spécifiquement la construction des protocoles d’examens selon les questions et les tournures de phrases qui les composent, est située dans la zone de l’examen pratique. Deuxièmement, selon l’adéquation entre le protocole d’examen pratique et l’évaluation d’apprentis en fin de formation (validité de contenu), cette validité est située entre les axes « Changement(s) » et « Autrui », car elle évalue également l’utilisation et l’application du protocole faites par le deuxième expert. Troisièmement, il y a la validité de conséquence, selon la congruence de l’outil entre les questions, le type de magasin et le plan de formation pour évaluer un futur professionnel. Cette validité est située entre « Soi(s) » et « Changement(s) », car les items évaluent l’expert sur l’écart qu’il ressent entre son référent (Figari, 1994) et le référent officiel du protocole d’examen.

Objectifs et hypothèses de recherche

Les réponses aux items du questionnaire doivent permettre d’extraire les trois dimensions de la validité de la procédure de qualification et de répondre à notre question de recherche : comment se distinguent les experts en fonction de leur évaluation de la validité de l’examen pratique?

Notre première hypothèse est qu’il existe plusieurs profils d’experts qui se distinguent selon les trois dimensions de la validité. Nous testerons la présence de ces profils par classes latentes. Notre deuxième hypothèse est que les experts, en fonction de leurs profils, fondent leur référentialisation principalement sur leur expérience. La fonction d’expert est occasionnelle, peu contrôlée et les protocoles d’examens pratiques ont une structure inchangée depuis 2004. Pour rappel, cette formation dure deux jours et a lieu en début de prise de fonction. En 2014, à la suite d’un changement de niveau taxonomique, une mise à niveau pour la deuxième journée a été proposée aux experts. Cependant, certains ont pu éluder la formation complète depuis quinze ans. Nous testerons la solidité de cette hypothèse avec les autres données sociodémographiques et certains items faisant appel à la référentialisation durant les examens pratiques.

Méthodologie

Les participants

Grâce à la base de données nationale des experts de la branche alimentation, la population des 457 experts a été sollicitée. Bien que la procédure de qualification soit de la responsabilité des cantons, les experts sont répartis en trois groupes, selon les régions linguistiques francophone, alémanique et italophone[2].

L’échantillon (n = 189) comporte 32 % de femmes et l’âge moyen est de 46 ans (M = 46,48, É.-T. = 9,96), représentant 41,35 % de la population. La formation suivie est à 28 % au niveau 5[3] selon la classification internationale type de l’éducation (CITE) et à 72 % au niveau CITE 6[4]. Les francophones représentent 36 % des réponses pour une proportion de 22 % dans la population. Les alémaniques représentent 59 % des réponses pour une proportion de 75 % et les italophones 5 % des réponses pour une proportion de 3 % dans la population. L’expérience moyenne pour la fonction d’expert est de 11 ans (M = 11,19 ; É.-T. = 6,92).

Les experts réalisent en moyenne dix expertises, ce qui représente approximativement trois jours de travail, à raison de trois à quatre expertises par journée, en moyenne, selon un rapport interne du domaine alimentaire du commerce de détail réalisé en 2023.

Ont été retirés de l’échantillon (n = 6), ceux ayant répondu en moins de six minutes, durée minimale d’une réponse de qualité selon des essais empiriques avec trois participants.

Les instruments

Pour évaluer les perceptions de la validité de contenu, la validité apparente et la validité de conséquence (Penta et al., 2005), onze items de type Likert ont été construits. Les modalités de réponses varient selon six niveaux, allant de « pas du tout d’accord ou ne me correspond pas du tout » à « tout à fait d’accord ou me correspond totalement ». L’instrument est composé de trois parties ; les items figurent en annexe.

Partie 1 - Questions générales sur l’examen pratique

Cette partie est construite selon des affirmations générales sur l’examen pratique auxquelles l’expert indique son degré d’adéquation. Par exemple, « De manière générale, vous trouvez que la durée de l’examen est trop longue » ou « Selon vous, les examens pratiques et les protocoles d’examens reflètent le travail quotidien des apprentis ».

Partie 2 - Questions sur la manière de répondre

La deuxième partie se base sur des captures d’écran de points spécifiques de l’examen pratique en version libre. En lien avec ces images, des questions et des affirmations sont soumises à l’expert, sur lesquelles il doit indiquer son degré d’adéquation.

Partie 3 - Données sociodémographiques

Les informations demandées sont le genre, l’âge, le plus haut niveau d’étude terminé ainsi que l’entreprise formatrice. Les entreprises ont été séparées en deux groupes, soit « Leader et Historique » désignant deux entreprises qui, selon l’Office fédéral de la statistique (2024), représentent 64 % du chiffre d’affaires du commerce de détail et « Autre » pour toutes les autres entreprises.

Pour les informations sur les examens pratiques, nous leur avons demandé le nombre d’années qu’ils avaient cumulées en tant qu’expert, le nombre d’expertises moyennes réalisées ainsi que le nombre d’apprentis que compte leur entreprise. L’expérience des experts est répartie en trois catégories : 1) moins de 3 ans, pour les experts peu ou pas expérimentés, 2) 3 à 15 ans, pour les experts expérimentés ayant uniquement fonctionné selon les protocoles d’examens pratiques de 2004 et 3) plus de 15 ans, pour les experts qui ont fonctionné selon les protocoles d’examens pratiques de 2004, mais également selon l’ordonnance précédente. La séparation entre ces deux derniers groupes est importante, car la précédente ordonnance sur la formation professionnelle imposait déjà une durée mais pas de protocole d’examen. Selon l’ancienne ordonnance de l’Office fédéral de la formation professionnelle et de la technologie (OFFT, 1980), les experts posaient aux apprentis les questions de leur choix.

L’instrument a été traduit en italien et en allemand. La version italienne a été validée par la responsable de cette région. La traduction de la version allemande a été validée selon la méthode Forward-Backward (Behling & Law, 2000). Seules des remarques concernant les abréviations des titres et des institutions ont été relevées. Aucune information sur le canton de fonctionnement n’a été demandée, car les experts sont fréquemment appelés à expertiser dans plusieurs cantons de leur région linguistique.

Les trois types de validité de l’examen

Quatre items sur la validité de contenu (Laveault & Grégoire, 2014 ; Penta et al., 2005) évaluent dans quelle mesure le protocole d’examen pratique est perçu comme un outil adéquat pour évaluer les apprentis. L’ensemble du déroulement de l’examen, ainsi que les questions posées par les experts, proviennent uniquement du protocole. Par conséquent, ce dernier doit à la fois refléter le travail quotidien et être un outil facilement utilisable.

La validité apparente, mesurée par trois items, est vue comme étant moins rigoureuse (Anastasi & Urbina, 1996 ; Nevo, 1985 ; Penta et al., 2005). Elle est cependant importante, car elle mesure l’acceptation et la crédibilité que les experts attribuent à l’examen. Toutes les questions du protocole sont construites selon une terminologie propre à ses concepteurs. Cependant, le langage professionnel, les termes techniques et les tournures de phrases changent selon les entreprises de formation. Par exemple, un même rayon est nommé « épicerie », « marchandise générale » ou « produits secs » selon les entreprises. Ainsi cette validité mesure la crédibilité que les experts attribuent aux termes choisis, mais également leur estimation de la capacité de l’apprenti à comprendre ces différents termes.

Quatre items servent finalement à mesurer les implications attribuées par les experts au protocole en tant qu’instrument de mesure, soit la validité de conséquence (Laveault & Grégoire, 2014 ; Messick, 1988 ; Penta et al., 2005). La note que les experts attribuent doit indiquer si l’apprenti est suffisamment compétent pour exercer comme professionnel qualifié.

La procédure d’administration de l’instrument

L’instrument a été soumis aux experts par courriel, la langue du message (français, allemand ou italien) est définie selon le choix de l’expert dans le système informatique de la branche. L’instrument, disponible en trois langues, a été complété par le logiciel d’enquête en ligne LimeSurvey. Durant le processus, l’expert avait la possibilité de choisir la langue de l’interface. L’appariement de l’expert à l’une des trois langues est défini selon celle qu’il a utilisée pour remplir l’enquête[5].

La réponse à chaque question a été définie comme obligatoire. Les consignes relatives aux objectifs de l’enquête étaient disponibles dans le courriel et sur LimeSurvey. L’instrument est resté accessible durant un mois et un courriel de rappel a été envoyé après deux semaines.

La procédure d’analyse

Des analyses factorielles exploratoires (AFE) ont été réalisées à partir des 11 items sur la validité. Les trois facteurs extraits ont été analysés avec le logiciel Mplus 8.3 afin de réaliser des profils en classes latentes. La composition des trois profils d’experts obtenus a été comparée grâce à des tests de Kruskal-Wallis.

Résultats

Dans notre recherche, plusieurs objectifs se dessinent. D’abord, nous cherchons à extraire les trois dimensions de la validité de la procédure de qualification selon notre cadre théorique. Ensuite, nous désirons distinguer des profils d’experts selon ces dimensions de la validité. Finalement, nous voulons expliquer ces profils selon les données sociodémographiques recueillies.

La validité de l’examen

Les AFE ont été conduites selon la méthode d’extraction de factorisation en axes principaux et une rotation Oblimin avec normalisation Kaiser (Stafford et al., 2006). Selon l’échantillon de 189 participants, seules les saturations dont la valeur était supérieure à 0,37 ont été prises en compte (Berger, 2021). Les trois facteurs extraits expliquent au total, 57,59 % de la variance. Le test de sphéricité de Bartlett est significatif et l’indice KMO est adéquat à 0,70 (Gagnon, 2019). La perception de la validité des examens pratiques est multidimensionnelle par le contexte de l’examen ainsi que le référent construit par l’expert. Ainsi, selon les conseils de Béland et al. (2018), nous donnons la cohérence interne par l’oméga de McDonald.

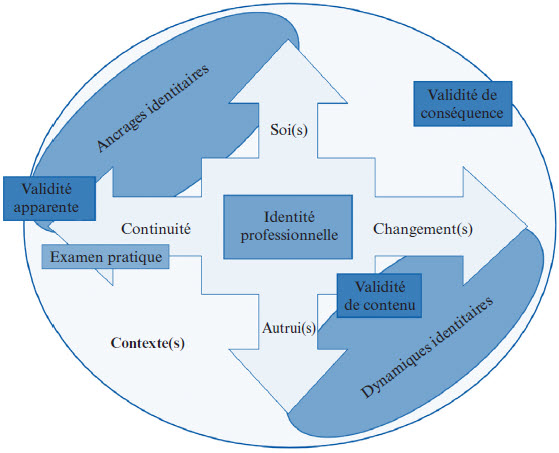

Le tableau 1 rapporte la matrice de pattern de cette solution factorielle.

Le premier facteur extrait correspond à la validité de contenu, compte quatre items, une valeur propre de 2,85 et explique 25,89 % de la variance dans les items. La cohérence interne est bonne avec un oméga de McDonald de 0,73. L’item « Je peux aisément attribuer 0 à 17 points pour la présentation » est conservé, bien qu’il ne sature que faiblement, car les 17 points possibles de cette question ont un poids important dans l’examen pratique pour deux raisons. Premièrement, selon le protocole, il faut accorder 15 minutes à cette question, ce qui représente un sixième du temps total. Deuxièmement, cette question est appareillée à quatre autres questions pouvant donner jusqu’à 8 points en plus. Ainsi, cette question vaut 25 points, donc le quart de l’examen.

Tableau 1

Matrice de pattern de la solution en trois facteurs

Le deuxième facteur extrait correspond à la validité apparente, compte trois items, une valeur propre de 2,21 et explique 20,07% de la variance dans les items. La cohérence interne est bonne avec un oméga de McDonald identique de 0,79.

Le troisième facteur extrait correspond à la validité de conséquence, compte quatre items, une valeur propre de 1,28 et explique 11,63 % de la variance dans les items. La cohérence interne est relativement faible avec un oméga de McDonald de 0,54.

Le profil des experts

Les scores des trois facteurs de validité, standardisés en scores Z, sont traités dans le logiciel Mplus 8.3 (Asparouhov & Muthen, 2012 ; Caron, 2018 ; Geiser, 2013 ; Nylund et al., 2007) pour l’extraction des profils d’experts.

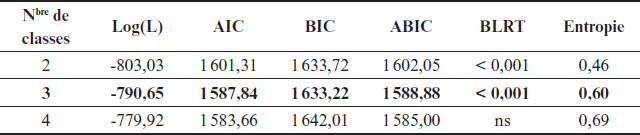

Selon les recommandations de Nylund et al. (2007) et en utilisant le test Bootstrap Likelihood Ratio Test (BLRT), reconnu pour sa robustesse dans ce contexte, nous avons conservé trois classes latentes, comme l’indique le tableau 2. Nylund et al. (2007) suggèrent effectivement de conserver la dernière classe latente, qui présente un résultat significatif (p < 0,01). Cette décision est renforcée par la valeur du test Bayesian Information Criterion (BIC), plus faible pour le modèle à trois classes, mettant ainsi en évidence la pertinence de cette configuration.

Tableau 2

Indices statistiques pour le choix du nombre de profils à retenir

Log(L), log likelihood ; AIC, Akaike Information Criterion ; BIC, Bayesian Information Criterion ; ABIC, Adjusted Bayesian Information Criterion ; BLRT, Bootstrap Likelihood Ratio Test

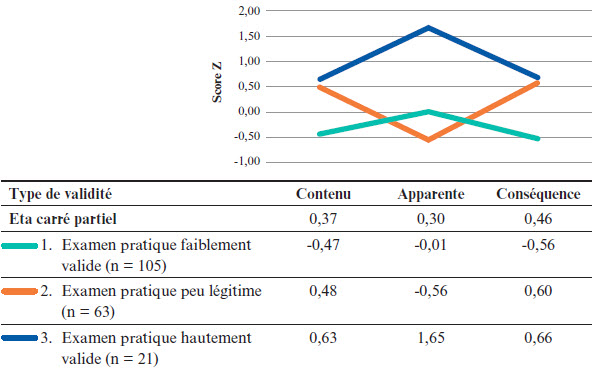

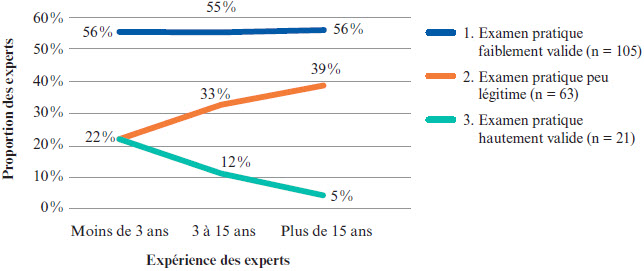

La figure 3 présente les moyennes de chacun des profils selon les types de validité.

Figure 3

Moyennes pour type de validité en fonction des profils d’experts

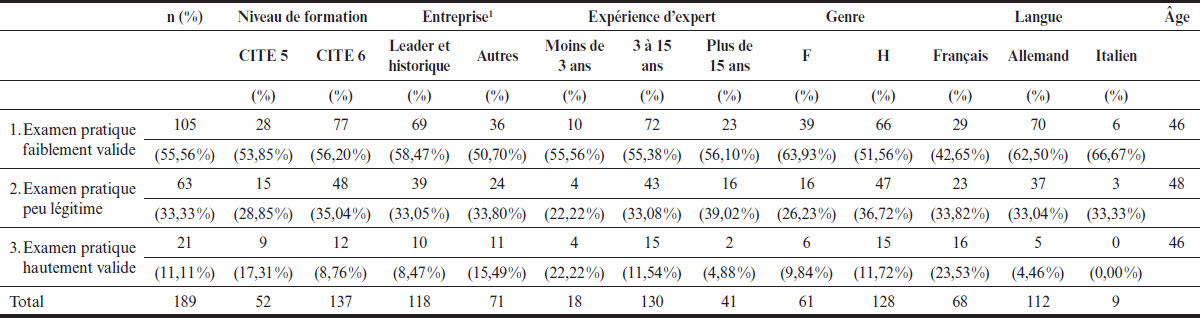

Le tableau 3 rapporte la composition de chacun des profils quant au niveau de formation, de l’entreprise, de l’expérience en tant qu’expert, du genre, de la langue et de l’âge. Il existe des différences dans la composition des profils quant à l’expérience en tant qu’expert et quant à la langue. La répartition des experts dans les profils est dépendante de l’expérience (F(1,186) = 3.15, p < 0,05 ; η2 = 0,03) et de la langue (χ2 (2) = 16,22 ; p < 0,001 ; V = 0,30). Au vu du peu d’italophones (n = 9), le test a été réalisé pour les alémaniques et pour les francophones. En revanche, nous trouvons que cette répartition est indépendante du niveau de formation, de l’entreprise, du genre et de l’âge des experts.

Le profil 1 : Examen pratique faiblement valide

Ce profil regroupe 56 % des experts de l’échantillon, soit 105 experts sur les 189 de l’échantillon complet. Ils évaluent la procédure d’examen pratique comme faiblement valide, tant du point de vue de la validité de contenu que de la validité de conséquence. Concernant la validité apparente, les experts se situent presque exactement à la moyenne de l’échantillon total en score Z (-0,01). La validité apparente attribuée à l’examen pratique (Anastasi & Urbina, 1996 ; Nevo, 1985 ; Penta et al., 2005) est dans la moyenne des autres experts, mais la validité de contenu (Laveault & Grégoire, 2014 ; Penta et al., 2005) dans la capacité de l’examen pratique en tant qu’outil à évaluer un professionnel ainsi que la validité de conséquence (Laveault & Grégoire, 2014 ; Penta et al., 2005) pour le processus de validation mis en place par cet examen sont en dessous des deux autres profils.

Tableau 3

Description des experts appartenant à chacun des profils

Note : Les pourcentages arrivent à un total de 100 % lorsqu’ils sont lus en colonne.

1. Les entreprises sont séparées en deux groupes : « Leader et historique » qui, comme le nom l’indique, correspondent aux deux entreprises historique et leader en Suisse et « Autres » pour toutes les autres entreprises.

Concernant la composition de ce profil selon la langue et l’expérience, il est plus adopté par les alémaniques (63 %) que par les francophones (43 %). L’expérience moyenne est de 11 ans (M = 11,45 ; É.-T. = 7,11), ce qui est similaire à l’ensemble des experts.

Le profil 2 : Examen pratique peu légitime

Ce profil regroupe 33 % des experts de l’échantillon, soit 63 experts. Ils évaluent positivement les validités de contenu et de conséquence (Penta et al., 2005) et considèrent l’examen pratique satisfaisant sur le fond. Cependant, la validité apparente est en dessous de la moyenne. Ainsi, les experts accordent peu de crédibilité à la construction et aux termes employés lors de l’examen pratique (Anastasi & Urbina, 1996 ; Nevo, 1985 ; Penta et al., 2005). Le protocole est perçu comme un outil adéquat pour réaliser l’examen, mais les termes qui y sont employés ne sont pas « appréciés ».

La composition de ce profil est pareillement répartie entre alémaniques (33 %) et francophones (34 %). L’expérience de 11 ans (M = 11,92 ; É.-T. = 6,54) de ce profil est également similaire à la moyenne générale.

Le profil 3 : Examen pratique hautement valide

Ce profil regroupe 11 % des experts de l’échantillon, soit 21 experts. L’examen pratique est perçu comme hautement valide selon les trois indicateurs construits (Anastasi & Urbina, 1996 ; Laveault & Grégoire, 2014 ; Messick, 1988 ; Penta et al., 2005). Les scores sont les plus élevés des trois profils. Les scores de validité de contenu et de conséquence sont similaires à ceux du profil 2 et plus élevés que ceux du profil 1. Les scores de validité apparente sont particulièrement plus élevés que ceux des deux autres profils, avec un score Z de 1,65. Les experts de ce profil accordent une grande validité à l’examen.

Selon la langue, ce profil est presque exclusivement composé de francophones (24 %). Il comporte seulement 4 % des alémaniques et aucun italophone. L’expérience est plus basse que dans les autres profils, à 8 ans (M = 7,71 ; É.-T. = 9,29).

Notre première hypothèse est vérifiée. Selon les types de validités de l’examen, nous avons pu découvrir trois profils d’experts.

Les caractéristiques sociodémographiques des profils d’experts

Selon notre deuxième hypothèse, nous testons les profils d’experts en fonction des différentes données sociodémographiques afin de tester si l’expérience en tant qu’expert est la principale source de référentialisation (Figari, 1994, 2006).

Le profil et l’expérience des experts

Les données étant éloignées d’une distribution normale, nous avons utilisé le test non paramétrique de Kruskal-Wallis. Ce test permet de déterminer s’il y a une différence entre les profils d’experts et une donnée observée. Le rang moyen nous renseigne sur le positionnement du groupe observé par rapport au rang moyen attendu.

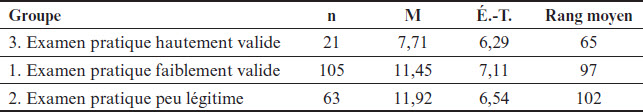

La différence d’évaluation de la légitimité de l’examen, comme l’illustre le tableau 4, est significative (H(2) = 7,49 ; p < 0,05) (Siegel, 1956) pour une taille d’effet de 4 % entre les profils et l’expérience des experts. L’écart entre le rang moyen attendu (95) et les trois rangs moyens montre que la tendance centrale de l’expérience en tant qu’expert n’est pas identique selon les profils. Ainsi l’expérience des experts selon les profils construits représente effectivement des populations distinctes.

Tableau 4

Profil des experts selon leur expérience moyenne

Les experts des profils 1 (Examen pratique faiblement valide) et 2 (Examen pratique peu légitime), qui indiquent une perspective contestant en partie la validité de l’examen, ont une expérience plus longue dans cette fonction. La figure 4 présente les trois profils d’experts selon les groupes d’expérience « Moins de 3 ans », « 3 à 15 ans » et « Plus de 15 ans ». Le profil 1 est similaire pour les trois groupes d’expérience en tant qu’expert. Les profils 2 et 3 sont identiques, à 22 %, dans le groupe des experts de moins de trois ans d’expérience mais divergent dans les deux groupes suivants. Pour les experts ayant plus de 15 ans d’expérience, le profil 3 ne représente que 5 % des experts alors qu’ils sont 39 % dans le profil 2. Précisons encore que nos données sont transversales et non longitudinales. Ainsi, nous avons des comparaisons entre les profils d’experts et non une évolution de ces derniers.

Figure 4

Profil des experts selon leur expérience

Cette information est appuyée par quatre autres résultats. Premièrement, en réalisant le test Kruskal-Wallis en remplaçant l’expérience par l’âge, le résultat est non significatif (H(2) = 0,81 ; ns), montrant ainsi que les années d’expérience sont liées aux profils des experts et non à leur âge. Deuxièmement, un test Kruskal-Wallis entre les trois profils d’experts (H(2) = 6,80 ; p < 0,05) avec l’item « La durée de l’examen […] est trop longue », non utilisé dans l’analyse factorielle, est aussi significatif. Ce qui signifie que le test est perçu comme trop long pour les classes « Examen pratique hautement valide » (moyenne de rang de 103) et « Examen pratique faiblement valide » (moyenne de rang de 102), mais pas pour la classe « Examen pratique peu légitime » (moyenne de rang de 81). Pour les experts ayant une expérience plus longue, la durée de l’examen pratique est trop courte pour réaliser une évaluation valide. Deux tests de khi carré révèlent que les profils ne diffèrent pas dans leur composition en termes de formation (χ 2(2) = 2,29 ; ns) ou de genre (χ 2(2) = 2,63 ; ns).

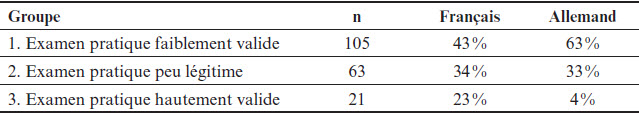

Le profil des experts selon leur langue

Une différence significative apparait selon la langue des experts (χ 2(2) = 16,22 ; p < 0,01 ; V = 0,30). Le test de khi carré a été réalisé avec les experts francophones et alémaniques. Les italophones n’ont pas pu être pris en compte, car une valeur inférieure à 5 apparait dans le tableau de la distribution théorique. Le tableau 5 montre la répartition des trois profils selon la langue.

Tableau 5

Profil des experts selon leur langue

Le profil 2 est de proportion identique entre les deux langues, tandis que le profil 3 semble être majoritairement présent parmi les experts francophones.

Discussion

Par des analyses factorielles exploratoires (AFE), nous avons pu extraire trois dimensions de la validité de la procédure de qualification. Ces dimensions nous ont ensuite permis de distinguer trois profils d’experts par une analyse en classes latentes. Nous avons finalement testé les liens entre ces profils et les données sociodémographiques récoltées. Cette discussion porte sur les différences significatives entre les profils des experts et leur perception de validité de l’examen pratique, puis la modulation de ce lien par l’expérience et par la langue de l’expert.

La validité de l’examen pratique selon les profils des experts

L’examen pratique est ainsi majoritairement perçu comme peu adapté pour les trois types de validité testés. Du point de vue de la validité de contenu (Laveault & Grégoire, 2014 ; Penta et al., 2005), le protocole d’examen pratique n’est pas considéré comme un bon outil pour évaluer les compétences des apprentis. Selon la validité de conséquence (Laveault & Grégoire, 2014 ; Nevo, 1985 ; Penta et al., 2005), il n’est pas vu comme un outil adéquat pour les différentes entreprises d’expertise. Finalement, en ce qui concerne la validité apparente (Anastasi & Urbina, 1996), l’examen pratique n’est pas perçu comme légitime en raison des tournures de phrase employées.

Nous émettons l’hypothèse que cette faible évaluation de la validité de l’examen pratique est attribuable à son absence d’évolution, devant rester dans la dimension de la continuité de l’ancrage identitaire (Perez-Roux, 2016). Le texte de loi ainsi que le plan de formation étant identiques depuis 2004, l’examen pratique est resté identique. De leur côté, les experts, spécialement ceux ayant cette fonction depuis 2004 ou avant, ont vu beaucoup de changements de leur identité professionnelle dans le commerce de détail. Leur travail quotidien ne se retrouve donc pas dans les protocoles d’examens actuellement en vigueur. Une autre hypothèse est liée au sentiment de lassitude ressenti par les experts pour des protocoles d’examens pratiques identique d’une année à l’autre. Le déroulement des examens suivant toujours le même fil rouge, l’expert expérimenté réalise la majorité de l’examen en se référant à peine à son protocole. Ainsi, il peut avoir l’impression que son propre ressenti est plus pertinent que les observations qu’il aurait dû reporter sur un protocole dont il ne perçoit plus l’utilité.

Selon l’expérience des experts

En nous basant sur les facteurs de validité de l’examen, nous avons pu construire trois profils significativement liés à l’expérience des experts.

Nous voyons que le profil 1 (Examen pratique faiblement valide), décrivant l’examen pratique comme faiblement valide, est similaire dans les trois groupes d’expérience. Ensuite, il est plus intéressant d’observer la différenciation qui s’opère entre les profils 2 et 3 (Examen pratique peu légitime et Examen hautement valide). Pour les experts ayant une expérience de moins de trois ans, la répartition entre les profils 2 et 3 est identique, à 22 %. L’évaluation de l’examen pratique comme étant hautement valide (profil 3) est de plus en plus faible dans les deux groupes d’expérience suivants et inversement pour l’évaluation de l’examen pratique comme étant peu valide (profil 2).

Nous ne parlerons pas d’une évolution, nos données étant transversales et non longitudinales, mais d’une différence entre les trois stades d’expérience des experts. Le troisième profil diminue autant que le deuxième augmente. La différence entre les deux profils est très majoritairement liée à la validité apparente de l’examen. Plus le nombre d’années d’expérience est élevé, plus la légitimité et le crédit (Anastasi & Urbina, 1996) que les experts accordent au protocole d’examen pratique baissent. Nous avançons deux hypothèses pour expliquer cette différence.

Premièrement, rappelons trois points sur la fonction d’expert : 1) ils suivent une formation unique de deux jours en début de carrière, 2) le protocole d’examen pratique est inchangé depuis 2004 et 3) la pratique de l’expertise occupe en moyenne deux journées annuellement. Les experts ont ainsi pu (dû) développer leur propre conception (Issaieva & Crahay, 2010) de la fonction d’expert et de la référentialisation (Figari, 1994) leur servant à l’évaluation. Le référent, ce qui doit être observé, devrait rester identique, mais la référentialisation est un processus dynamique construit par l’écart entre le référent et le référé qui représente la réalité observée par les experts. Celui-ci a évolué avec les années d’expertise et les pratiques des entreprises, inconnues dans les premières années d’expertise, sont devenues familières. Les experts construisent ainsi un référentiel dont le référent original devient un lointain souvenir. La crédibilité attribuée à une procédure non évolutive baisse au fur et à mesure de l’expérience accumulée.

Deuxièmement, cette évaluation d’une faible validité de l’examen, plus élevée selon l’expérience des experts, est significativement liée avec l’item décrivant l’examen pratique comme trop court. Cette corrélation montre une différence dans l’évaluation des experts. On s’éloigne d’une démarche strictement sommative servant à attribuer une note à un examen pratique pour aller vers une démarche herméneutique (De Ketele, 2010) pour laquelle l’expert va évaluer la qualité de la réflexion en action (Perrenoud, 2001). Cette recherche de signes parlants (Hadji, 2012) issus des pratiques professionnelles (Le Boterf, 2010) mis en perspective avec l’expérience grandissante des experts prend du temps.

D’autres indicateurs soutiennent cette analyse axée sur l’expérience des experts. Pour rappel, le genre, l’âge, le niveau de formation et le type d’entreprise ne sont pas significativement liés aux profils d’experts. Seule la langue (français ou allemand) montre une différence significative. Celle-ci fait l’objet du chapitre suivant.

Selon la langue des experts

Comme le montrait le tableau 5 illustrant le profil des experts selon leur langue, environ un tiers des experts des deux langues évaluent l’examen pratique comme peu légitime. La principale différence porte sur le profil 3, décrivant l’examen pratique comme hautement valide, qui représente 4 % des alémaniques mais 23 % des francophones.

Nous attribuons cette différence à une prise de fonction différente entre les experts des deux régions linguistiques. Les francophones débutent en tant qu’experts évaluateurs dès leur nomination tandis que les alémaniques débutent en tant qu’observateurs d’experts qui leur serviront de modèles durant leur première année de fonction. Ainsi, un expert francophone qui vient de finir sa formation va expertiser avec un deuxième expert et est directement impliqué dans l’évaluation. Pour un expert alémanique, sa première année en tant qu’observateur d’un duo d’experts modèles lui permet d’observer sans avoir la responsabilité de l’évaluation.

Cette méthode alémanique, passant par une année d’observation, permet davantage d’échanges sur des pratiques formelles et informelles pour un bon examen pratique entre les deux experts expérimentés et l’expert novice. Cependant, le choix des experts modèles s’effectue parmi les plus expérimentés qui, comme nous l’avons vu précédemment, ont un profil évaluant l’examen pratique comme faiblement valide. Ainsi, ils pourraient orienter les nouveaux experts selon leurs propres avis à propos de l’examen.

Limites et piste pour une future étude

L’échantillonnage de la population présente un déséquilibre de participation des francophones par rapport aux alémaniques, donnant aux premiers un poids plus grand dans la représentation des données. Les conclusions pourraient différer avec un échantillon plus représentatif selon la répartition des langues au niveau fédéral. Cette différence restant cependant peu importante dans les résultats obtenus, nous trouverons seulement une présence plus marquée des experts francophones dans le profil des examens pratiques perçus comme hautement valides.

Ensuite, bien que la branche alimentation représente 28,56 % des examens de la profession de gestionnaire du commerce de détail (Office fédéral de la statistique, 2023), notre recherche est spécifique à une branche. Une étude de plus grande ampleur permettrait de faire la différence entre des résultats spécifiques à ce contexte et ceux qui sont généraux à la profession.

Une autre limite, ou plutôt un point d’attention, est la projection d’une évolution des profils des experts selon leur expérience. Comme notre étude est transversale et non longitudinale, nous ne savons pas de quelle manière évolue l’évaluation de la validité des examens par les experts. Mais nous voyons que le collège d’experts actuel montre des profils sur l’évaluation de la validité des examens significatifs selon leur expérience. Pour confirmer ou infirmer cette information, il faudrait reconduire l’étude plusieurs fois.

Les trois profils construits ainsi que l’expérience des experts seront utilisés comme objet d’attention et outil de création des groupes pour deux séances de focus group. Cette étude sera l’occasion de mettre au centre des échanges les conceptions des experts quant à leur rôle tout en faisant émerger les représentations sociales sur les fonctions et sur les pratiques des experts par leurs interactions. Le focus group aura également pour objectif de faire échanger les experts sur ce qu’ils veulent observer comme indicateurs chez un apprenti pour dire qu’il est compétent.

Conclusion

Une faible évaluation de la validité de l’examen pratique de la part des experts ressort de notre étude. En prenant l’expérience des experts comme point de repère, nous avons montré qu’avec une expérience de 15 ans ou plus, l’examen pratique n’est presque jamais perçu comme hautement valide. Nous avons posé les hypothèses a) d’un manque de formation continue des experts et b) d’un décalage entre un examen pratique ancré en 2004 et une dynamique identitaire des professionnels en constante évolution.

Ainsi, la solution idéale serait une adaptation plus fréquente des protocoles d’examens combinée à de la formation continue.

Cette solution est complexe d’une manière tant externe qu’interne à l’examen pratique. Sur le plan externe, elle est complexe par l’ampleur des conséquences d’un changement, l’examen pratique n’étant pas une procédure détachée de la formation professionnelle initiale. Il représente l’aboutissement de celle-ci. Ainsi, une modification de l’examen pratique demanderait que la procédure de préparation à celui-ci soit également adaptée, ce qui inclut la formation des enseignants et des formateurs des cours interentreprises, des écoles professionnelles et des entreprises formatrices. Deuxièmement, de manière interne, ces changements une fois décidés doivent être transmis par de la formation continue aux experts afin qu’ils puissent les appliquer. La fonction d’expert est une occupation ponctuelle puisque certains vont expertiser durant un ou deux jours une année, puis feront une pause l’année suivante. Ainsi, le risque concret est grand que le nombre d’experts ne soit pas suffisant au moment des examens, car l’expert doit à la fois être disponible et avoir suivi la formation adaptée à l’examen en cours de validité.

Appendices

Annexes

Annexe A. Échelles et items de validité des examens pratique

A. Questions générales sur la procédure de qualification

Cette série de questions s’intéresse à vous en tant qu'expert ainsi que ce que vous pensez de l'examen pratique actuel pour évaluer un futur professionnel.

Veuillez répondre pour chaque question, selon votre degré d'accord, entre :

1 = Pas du tout d'accord/ne me correspond pas du tout

6 = Tout à fait d'accord/me correspond totalement

De manière générale, vous trouvez que...

-

Le travail en duo des experts permet d’évaluer de manière plus fiable.

-

Une formation annuelle ou remise à niveau est nécessaire.

-

La durée de l’examen GCD (90 minutes) est trop longue.

-

Par les expertises que je réalise, il y a moins d’échecs aux examens pratiques.

-

Je me sens compétent comme expert.

-

La note donnée est proche de celle que je donnerais sans avoir besoin de rédiger le protocole.

-

Les questions sont difficiles du point de vue des termes techniques.

-

Les questions sont difficiles du point de vue de la langue.

-

Les questions sont similaires entre les protocoles d’examen et la série zéro.

-

Les tournures de phases rendent les questions difficiles.

-

Je trouve qu’il existe une différence de difficulté entre les questions posées aux ACD et celles posées aux GCD.

Selon vous les examens pratiques et les protocoles d'examens...

-

Sont orientés vers de la restitution de théorie.

-

Sont suffisants pour certifier que l’apprenti est un professionnel compétent.

-

Reflètent le travail quotidien des apprentis.

-

Ont un niveau de difficulté adapté pour certifier les compétences d’un gestionnaire du commerce de détail.

-

Rendent difficile l’attribution des points (par exemple jeu de rôle avec : 1 pt = insatisfaisant, 2 pts = satisfaisant et 3 pts = très bon)

Annexe B. Protocoles d'examens

Les questions portent sur l'utilisation des protocoles d'examen. Toutes les questions sont issues de la série zéro des gestionnaires du commerce de détail en produits nutritifs et stimulants.

Les questions sont générales, mais des captures d'écran d'exemple de questions sont ajoutées pour mieux comprendre la question.

Veuillez répondre pour chaque question, selon votre degré d'accord, entre :

1 = Pas du tout d'accord/ne me correspond pas du tout

6 = Tout à fait d'accord/me correspond totalement

Durant l'examen, vous arrivez sur une question qui vous semble trop difficile pour l’apprenti. Quelle est votre réaction ?

-

Je reformule la question avant de la poser.

-

Je reformule la question suite aux réponses de l’apprenti.

-

Je pose la question telle que notée dans le protocole et complète d’une reformulation personnelle.

-

Je me déplace dans un rayon pour permettre à l’apprenti de mieux comprendre la question.

-

Si la question figure dans le protocole, l’apprenti doit pouvoir y répondre.

-

Je pense que le niveau de difficulté de cette question est élevé par rapport aux autres questions, mais je ne fais rien.

Après avoir posé la question, la réponse de l’apprenti ne va pas dans le sens de la liste de solutions. Quelle est votre réaction ?

-

Je me demande si j’ai mal posé la question.

-

Je relis la question dans les mêmes termes et demande si tout est bien compris.

-

Je demande à l’apprenti de reformuler, avec ses propres mots, ma question.

-

D’un contact visuel avec l’expert 2, j’ai la confirmation que la question est correctement posée.

Vous comparez les réponses des apprentis et les listes de solutions dans les protocoles. Quelles sont vos expériences ?

-

Les réponses des apprentis correspondent à la liste de solutions.

-

Les réponses des apprentis sont plus concrètes que celles de la liste de solutions.

-

Les réponses de la liste de solutions me semblent correspondre aux pratiques du commerce de détail actuel.

-

Je me sens libre de donner des points à des réponses non inscrites dans la liste de solutions.

Dans l’attribution des points de la question de la « semaine d’action »...

-

Je peux aisément attribuer 0 à 17 points pour la présentation.

-

Les présentations des apprentis me semblent généralement cohérentes pour leurs magasins.

-

Les présentations des apprentis me semblent généralement cohérentes avec la théorie.

-

Je différencie facilement les trois compétences (professionnelle, méthodologique et sociale) à évaluer dans l’analyse de la présentation.

Notes

-

[1]

Mes remerciements à Beaudouin Laura, Daenzer Annabelle, Lanini Anastasia, Meynet Alexane, Péquignot Mathis, Rana Mariastella et Romanski Soraya qui ont participé à extraire les trois dimensions de la validité de la procédure de qualification durant le séminaire Pratiques de recherche du semestre de printemps 2023 à l’université de Fribourg.

-

[2]

Pour l’apprenti, le choix de la langue est défini dans son contrat de travail (français, allemand ou italien) et conditionnera la langue des cours et de son examen pratique.

-

[3]

Les diplômes courants sont le certificat fédéral de capacité ou la maturité réalisée en école professionnelle.

-

[4]

Les diplômes courants sont le brevet fédéral ou un diplôme obtenu en école spécialisée.

-

[5]

Nous utiliserons par la suite des termes tels que « experts francophones », bien quelques experts bilingues fonctionnent occasionnellement dans une autre langue.

Liste des références

- Anastasi, A. & Urbina, S. (1996). Psychological Testing (7e éd.). Pearson.

- Angoff, W. H. (1984). Scales, norms, and equivalent scores. Educational Testing Service.

- Asparouhov, T. & Muthen, B. (2012). Using Mplus TECH11 and TECH14 to test the number of latent classes. Mplus Web Notes, 14(22), 1‑17.

- Bain, D. (2017). Fixer un seuil de suffisance pour une épreuve de maîtrise : Apports et limites de la méthode d’Angoff. Évaluer - Journal international de recherche en éducation et formation, 3(3), 69‑95.

- Behling, O. & Law, K. S. (2000). Translating Questionnaires and Other Research Instruments. SAGE Publications. https://doi.org/10.4135/9781412986373

- Béland, S., Cousineau, D. & Loye, N. (2018). Utiliser le coefficient omega de McDonald à la place de l’alpha de Cronbach. McGill Journal of Education, 52(3), 791‑804. https://doi.org/10.7202/1050915ar

- Berger, J.-L. (2021). Analyse factorielle exploratoire et analyse en composantes principales : Guide pratique. https://doi.org/10.13140/RG.2.2.16206.18246

- Berger, J.-L., Wenger, M. & Sauli, F. (2021). What constitutes quality in the Swiss initial vocational education and training dual system: An apprentice perspective. Dans M. J. Chisvert Tarazona, M. Moso Diez & F. Marhuenda Fluixá (dir.), Apprenticeship in dual and non-dual systems: Between tradition and innovation (p. 79‑103). Peter Lang.

- Berger, J.-L., Wenger, M. & Sauli, F. (2023). Engagement en formation professionnelle initiale duale et perceptions de la qualité de la formation. Didactique, 4(2), 33‑64. https://doi.org/10.37571/2023.0203

- Bloom, B. S. (1969). Taxonomie des objectifs pédagogiques (M. Lavallée, trad.). Éducation nouvelle.

- Bressoux, P. (2018). Comment se fabrique le jugement des enseignants? Regards croisés sur l’économie, 22(1), 15‑23. https://doi.org/10.3917/rce.022.0015

- Brown, J. S., Collins, A. & Duguid, P. (1989). Situated Cognition and the Culture of Learning. Educational Researcher, 18(1), 32‑42. https://doi.org/10.3102/0013189X018001032

- Caron, P.-O. (2018). La modélisation par équations structurelles avec Mplus. Presses de l’Université du Québec.

- De Ketele, J.-M. (2010). Ne pas se tromper d’évaluation. Revue française de linguistique appliquée, 15(1), 25‑37. https://doi.org/10.3917/rfla.151.0025

- Delahais, T., Devaux-Spatarakis, A., Revillard, A. & Ridde, V. (2021). Introduction : Qui évalue et comment? Dans Évaluation. Fondements, controverses, perspectives. Éditions science et bien commun. https://doi.org/10.5281/zenodo.6336071

- Figari, G. (1994). Évaluer : Quel référentiel? De Boeck.

- Figari, G. (2006). Les référentiels entre théorie et méthodologie. Dans G. Figari et L. Mottier Lopez (dir.), Recherche sur l’évaluation en éducation : Problématiques, méthodologies et épistémologie : 20 ans de travaux autour de l’ADMEE-Europe (p. 101‑108). L’Harmattan.

- Formation du Commerce de Détail Suisse. (2021a). Plan de formation Assistant/Assistante du commerce de détail avec attestation fédérale de formation professionnelle (AFP). https://www.bds-fcs.ch/fr/Medias-digitaux/Download-Center?category=27&disposition=attachment&download=16&searchTerm=taxonomie

- Formation du Commerce de Détail Suisse. (2021b). Plan de formation Gestionnaire du commerce de détail avec certificat fédéral de capacité (CFC). https://www.bds-fcs.ch/fr/Medias-digitaux/Download-Center?category=27&disposition=attachment&download=16&searchTerm=taxonomie

- Frey, M. (dir.). (2010). Il y a encore des lieux de formation qui ne collaborent pas bien : Évaluation des procédures de qualification dans la formation professionnelle initiale. Folio : la revue BCH | FPS pour les enseignants de la formation professionnelle, 5, 4‑7.

- Gagnon, R. J. (2019). Measurement Theory and Applications for the Social Sciences. Measurement: Interdisciplinary Research and Perspectives, 17(4), 209‑210. https://doi.org/10.1080/15366367.2019.1610343

- Geiser, C. (2013). Data analysis with Mplus. The Guilford Press.

- Gomensoro, A., Meyer, T., Hupka-Brunner, S., Jann, B., Müller, B., Oesch, D., Rudin, M. & Scharenberg, K. (2017). Situation professionnelle à l’âge de trente ans. Mise à jour des résultats de l’étude longitudinale TREE. TREE.

- Grisay, A. (2006). Réflexions sur l’« effet-école ». Dans G. Figari et L. Mottier Lopez (dir.), Recherche sur l’évaluation en éducation : Problématiques, méthodologies et épistémologie : 20 ans de travaux autour de l’ADMEE-Europe (p. 34‑43). L’Harmattan.

- Hadji, C. (2012). Faut-il avoir peur de l’évaluation? De Boeck Supérieur.

- Hayes, A. F. & Krippendorff, K. (2007). Answering the call for a standard reliability measure for coding data. Communication Methods and Measures, 1(1), 77‑89. https://doi.org/10.1080/19312450709336664

- Issaieva, É. & Crahay, M. (2010). Conceptions de l’évaluation scolaire des élèves et des enseignants : Validation d’échelles et étude de leurs relations. Mesure et Évaluation en Éducation, 33(1), 31‑61. https://doi.org/10.7202/1024925ar

- Jan, D. (2023, 8 juin). Divergences inter-juges : En utilisant le protocole d’examen de fin d’apprentissage en alternance dans le commerce de détail. Printemps de la Recherche en Éducation 2023 - Réseau des INSPÉ, Paris. https://doi.org/10.5281/ZENODO.7937207

- Kägi, W. (2010). Évaluation des procédures de qualification dans la formation professionnelle initiale. Office fédéral de la formation professionnelle et de la technologie. https://edudoc.ch/record/38694/files/Schlussbericht_f.pdf

- Kriesi, I., Neumann, J., Schweri, J., Kuhn, A. & Baumeler, C. (2016). Rester? S’en aller? Recommencer? Fréquence, causes et répercussions des résiliations de contrats d’apprentissage. Observatoire suisse de la formation professionnelle. Zollikofen : Institut fédéral des hautes études en formation professionnelle IFFP. OBS IFFP. https://www.hefp.swiss/sites/default/files/downloads/obs_trendbericht_lva_20160826_fr.pdf

- Kuster, H. (2011). Des procédures de qualification différentes pour les apprentis. La revue BCH | FPS pour les enseignants de la formation professionnelle, 6, 18.

- Laveault, D. & Grégoire, J. (2014). Introduction aux théories des tests en psychologie et en sciences de l’éducation (3e éd.). De Boeck.

- Le Boterf, G. (2010). Professionnaliser : Construire des parcours personnalisés de professionnalisation (6e éd.). Eyrolles-Éd. d’Organisation.

- Loye, N. (2019). Et si la validation était plus qu’une suite de procédures techniques? Mesure et Évaluation en Éducation, 41(1), 97‑123. https://doi.org/10.7202/1055898ar

- Merle, P. (2018). Les pratiques d’évaluation scolaire : Historique, difficultés, perspectives. PUF.

- Messick, S. (1988). Meaning and values in test validation: The science and ethics of assessment. ETS Research Report Series, 1988(2), i‑28. https://doi.org/10.1002/j.2330-8516.1988.tb00303.x

- Mottier Lopez, L. (2015). Évaluations formative et certificative des apprentissages : Enjeux pour l’enseignement. De Boeck.

- Mottier Lopez, L. & Allal, L. (2008). Le jugement professionnel en évaluation : Un acte cognitif et une pratique sociale située. Swiss Journal of Educational Research, 30(3), 455‑464. https://doi.org/10.24452/sjer.30.3.4798

- Nevo, B. (1985). Face validity revisited. Journal of Educational Measurement, 22(4), 287‑293. https://doi.org/10.1111/j.1745-3984.1985.tb01065.x

- Nylund, K. L., Asparouhov, T. & Muthén, B. O. (2007). Deciding on the Number of Classes in Latent Class Analysis and Growth Mixture Modeling: A Monte Carlo Simulation Study. Structural Equation Modeling: A Multidisciplinary Journal, 14(4), 535‑569. https://doi.org/10.1080/10705510701575396

- Office fédéral de la statistique. (2023). Formation professionnelle initiale : Tableaux de base - 2022 | Tableau (su-f-15.03.02.01.01_2022). https://www.bfs.admin.ch/asset/fr/24468965

- Office fédéral de la statistique. (2024). Statistique des chiffres d’affaires du commerce de détail—Séries annuelles (px-x-0603020000_104). Office fédéral de la statistique. https://www.bfs.admin.ch/bfs/fr/home.assetdetail.30546933.html

- OFFT (1980). Gestionnaire de vente, 70200.

- Penta, M., Arnould, C. et Decruynaere, C. (2005). Développer et interpréter une échelle de mesure : Applications du modèle de Rasch. Mardaga.

- Perez-Roux, T. (2016). Accompagnement et reconnaissance d’autrui : Quels enjeux pour l’évaluation en formation? Dans A. Jorro & Y. Mercier-Brunel (dir.), Activité évaluative et accompagnement professionnel (p. 99‑116). Presses universitaires François-Rabelais. https://doi.org/10.4000/books.pufr.18121

- Perrenoud, P. (2000). Mobiliser ses acquis : Où et quand cela s’apprend-il en formation initiale? De qui est-ce l’affaire? Recherche & Formation, 35(1), 9‑23. https://doi.org/10.3406/refor.2000.1667

- Perrenoud, P. (2001). Développer la pratique réflexive dans le métier d’enseignant professionnalisation et raison pédagogique. ESF éditeur.

- Perrenoud, P. (2010). Et si l’évaluation institutionnelle paralysait le développement professionnel? Dans L. Paquay, C. Van Nieuwenhoven et P. Wouters (dir.), L’évaluation, levier du développement professionnel? (p. 35‑47). De Boeck Supérieur ; Cairn.info. https://doi.org/10.3917/dbu.paqua.2010.01.0035

- Perrenoud, P. (2012). Le travail sur l’habitus dans la formation des enseignants. Analyse des pratiques et prise de conscience. Dans L. Paquay, M. Altet, É. Charlier & P. Perrenoud (dir.), Former des enseignants professionnels : Quelles stratégies? Quelles compétences? (p. 211‑237). De Boeck Supérieur.

- Réjane, D. (2023). Résiliation du contrat d’apprentissage, réentrée, statut de certification—Résultats pour la formation professionnelle initiale duale (AFP et CFC), édition 2023 (1642‑2300). Office fédéral de la statistique. https://www.bfs.admin.ch/asset/fr/29645528

- Reuter, Y., Cohen-Azria, C., Daunay, B., Delcambre, I. & Lahanier-Reuter, D. (2013). Évaluation. Dans Dictionnaire des concepts fondamentaux des didactiques (p. 101‑105). De Boeck Supérieur. https://doi.org/10.3917/dbu.reute.2013.01.0101

- Schmid, E. & Stalder E., B. (dir.). (2008). Évaluation de l’étude bernoise LEVA. Pourquoi les jeunes changent de métier durant l’apprentissage. Panorama, Nr. 1 (2008), 1.

- Scriven, M. (1996). Types of Evaluation and Types of Evaluator. Evaluation Practice, 17(2), 151‑161.

- SEFRI. (2004). Ordonnance sur la formation professionnelle (OFPr). Secrétariat d’État à la formation, la recherche et l’innovation. https://www.fedlex.admin.ch/eli/cc/2003/748/fr

- SEFRI. (2022). La formation professionnelle en Suisse – Faits et chiffres 2022. Secrétariat d’État à la formation, la recherche et l’innovation. https://www.sbfi.admin.ch/dam/sbfi/fr/dokumente/webshop/2020/bb-f-z-2020.pdf.download.pdf/fakten_zahlen_bb_f.pdf

- Seufert, S. (2018). Flexibilisierung der Berufsbildung im Kontext fortschreitender Digitalisierung. Secrétariat d’État à la formation, à la recherche et à l’innovation. https://www.sbfi.admin.ch/sbfi/de/home/dienstleistungen/publikationen/publikationsdatenbank/berufsbildung-digitalisierung.html

- Siegel, S. (1956). Nonparametric Statistics for the Behavioral Sciences. McGraw-Hill.

- Stafford, J., Bodson, P. & Stafford, M.-C. (2006). L’analyse multivariée avec SPSS. Presses de l’Université du Québec.

- Stern, S., Ehrler, J., Marti, C. et von Stokar, T. (dir.). (2010). Évaluation de la formation professionnelle initiale de deux ans (AFP) : Version abrégée. OFFT.

- Tellenbach, D. (2022). Plaidoyer pour une meilleure procédure de qualification : Examens finals dans la formation professionnelle initiale : Une aberration? Transfer. Formation professionnelle dans la recherche et la pratique, 7(3).

- Vial, M. (2012). L’évaluation située. De Boeck Supérieur.

List of figures

Figure 1

Question issue d’un protocole de l’examen pratique

Figure 2

Transactions identitaires (Adapté de Perez-Roux, 2016, p. 4)

Figure 3

Moyennes pour type de validité en fonction des profils d’experts

Figure 4

Profil des experts selon leur expérience

List of tables

Tableau 1

Matrice de pattern de la solution en trois facteurs

Tableau 2

Indices statistiques pour le choix du nombre de profils à retenir

Tableau 3

Description des experts appartenant à chacun des profils

Note : Les pourcentages arrivent à un total de 100 % lorsqu’ils sont lus en colonne.

1. Les entreprises sont séparées en deux groupes : « Leader et historique » qui, comme le nom l’indique, correspondent aux deux entreprises historique et leader en Suisse et « Autres » pour toutes les autres entreprises.

Tableau 4

Profil des experts selon leur expérience moyenne

Tableau 5

Profil des experts selon leur langue